Noticia original: Como todos los años, Epic Games ha querido hacer suya la Game Developers Conference con la presentación de las últimas características añadidas al motor Unreal Engine. Que en esta edición del evento han sido de gran calado. La más importante de ellas tal vez sea el soporte para la tecnología de trazado de rayos a través de DirectX Raytracing, una interesantísima tecnología gráfica de la que os hablábamos hace muy poco y que destaca por su capacidad para plasmar sombras, reflejos y efectos de iluminación de altísima calidad.

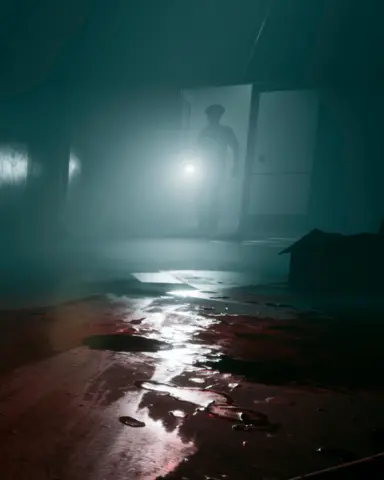

Epic ha recurrido a su asociación con Disney para la demo, haciendo protagonistas del segmento a la tropa de asalto de La Guerra de las Galaxias. Todo el segmento se ejecuta en tiempo real (no se puede pedir menos a Unreal Engine), mostrando las posibilidades gráficas abiertas por la incorporación de DirectX Raytracing al repertorio de trucos del motor.

Lo que la compañía no ha señalado es la clase de hardware necesario para mover la demo. Será sin duda sustancial.

La aceleración del trazado de rayos por hardware solo está presente en estos momentos en las tarjetas Titan V de Nvidia, con un precio de 3.100 euros, y de hecho EA Seed se llevó tres unidades para la también impactante demostración técnica de Project PICA PICA. A estas alturas no cabe la menor duda de que esta es una prestación que solo comenzará a ser explotada seriamente cuando Nvidia lance su generación de tarjetas de consumo basadas en Volta.

Animaciones faciales mucho más detalladas

Además de sus avances gráficos relacionados con el raytracing, Epic también ha querido ilustrar las capacidades de animación facial avanzadas incorporadas en Unreal Engine. Adentrándonos de lleno en el valle inquietante, la actriz china Bingjie Jiang ha cedido su rostro para dar vida a un avatar generado en tiempo real usando un sistema de captura muy parecido al utilizado en el desarrollo de Hellblade, pero que aparentemente no requiere de marcadores sobre la piel.

Tal vez aún más espectacular es la demo protagonizada por el siempre expresivo Andy Serkis, más conocido por interpretar a Gollum (El Señor de los Anillos), César (El Planeta de los Simios) y Ulysses Klaue (Marvel). No solo por el realismo de su digitalización, sino por la impactante forma en la que sus gestos pueden ser exportados a modelos con una fisionomía alejada de la humana.

3DMark y AMD se vuelcan también con el raytracing

En otro orden de cosas pero sin dejar el trazado de rayos, Futuremark ha dado a conocer una nueva demo sobre DirectX Raytracing. Todavía no disponible públicamente (ni prisa que le corre a los finlandeses viendo la que lleva Nvidia), este nuevo benchmark sirve para mostrar el potencial gráfico en tiempo real de la nueva API de Microsoft.

Entre las prestaciones enumeradas por la compañía se cuentan el renderizado de reflejos en tiempo real y con gran precisión de objetos dinámicos, incluyendo aquellos que existen fuera de la cámara principal, y reflejos con corrección de perspectiva sobre todas las superficies en escena, incluyendo aquellas que normalmente no incorporarían este efecto.

El sitio oficial de la compañía tiene varias capturas animadas de gran tamaño ilustrando dichos efectos con mayor claridad.

Por último, AMD ha confirmado en la GDC la incorporación de la tecnología de trazado de rayos en tiempo real en el motor de renderizado Radeon ProRender. Su implementación se realizará de forma mixta con el habitual renderizado por rasterización para mejorar los efectos de iluminación.

A diferencia de Nvidia RTX, que tiene un carácter bastante general y funciona con DirectX, ProRender se basa en Vulkan y apunta a un público estrictamente profesional. Ingenieros y arquitectos serán los primeros usuarios en poder sacarle provecho, sin que por ahora haya información oficial alguna sobre cuándo dará AMD soporte por software para sus actuales tarjetas gráficas o cuándo lanzará modelos de consumo con aceleración por hardware.